9月11日消息,摩爾線程正式發布并開源大模型分布式訓練仿真工具SimuMax v1.0,在顯存和性能仿真精度上實現了突破性提升,同時引入多項關鍵功能,進一步增強了模型兼容性、靈活性。

SimuMax是一款專為大語言模型(LLM)分布式訓練負載設計的仿真模擬工具,可為從單卡到萬卡集群提供仿真支持。

它無需實際執行完整訓練過程,即可高精度模擬訓練中的顯存使用和性能表現,幫助用戶提前了解訓練效率,優化計算效能。

基于靜態分析模型,摩爾線程自研的SimuMax通過結合成本模型、內存模型和屋頂模型,實現對訓練過程的精準仿真。

該工具支持多種主流分布式并行策略與優化技術,適用于以下多種應用場景:

1、并行策略:

數據并行(DP)、張量并行(TP)、序列并行(SP)、流水線并行(PP)、專家并行(EP)

2、優化技術:

ZeRO-1、完整重計算、選擇性重計算、融合內核等。

3、適用對象:

希望尋找最優訓練策略以提升效率的用戶;

從事框架或大模型算法開發的工程師,用于優化與調試;

芯片制造商,用于性能預測與硬件設計輔助。

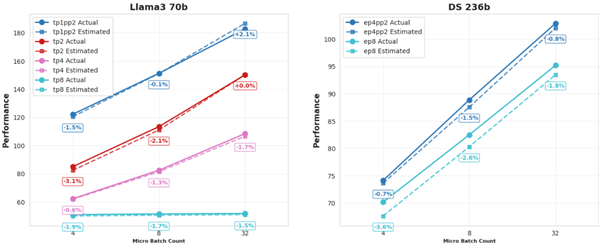

SimuMax 1.0最顯著的更新在于其仿真精度的大幅提升,為用戶提供更可靠的分析結果。

針對Dense和MoE(混合專家)模型,顯存估計誤差穩定控制在1%以內。

經測試,在多個主流GPU上,目前最優性能估計誤差持續低于4%。

此外,SimuMax 1.0還引入了多項新特性,支持更廣泛的模型結構和高效率訓練需求:

MLA支持:

新增對MLA模型架構的支持;

流水線并行(PP)增強:

支持對首階段和末階段層的細粒度控制,優化模型分片策略;

MoE靈活性提升:

在混合專家(MoE)模型中支持自定義Dense層,為模型設計提供了更大的靈活性。

Megatron兼容:

提供簡化的模型遷移流程,可輕松轉換和分析基于Megatron框架的模型,提升與現有生態的互操作性。

重計算策略優化:

實現更細粒度的選擇性重計算,支持更精準的內存和計算資源權衡。

全面的效率分析:

新增對不同張量形狀與內存布局下計算效率與利用率的評估功能。