摘要:針對(duì)現(xiàn)有特征唇印提取中信息處理量較大、識(shí)別率不高等問(wèn)題,本文提出了基于內(nèi)唇輪廓的特征唇印提取算法。算法首先在基元圖像上對(duì)內(nèi)唇輪廓特征點(diǎn)進(jìn)行標(biāo)定,建立基元唇印模型,然后通過(guò)均值計(jì)算構(gòu)造普通模型,并利用Gabor變換對(duì)基元唇印和普通模型進(jìn)行聯(lián)合特征信息提取,最后通過(guò)相似度對(duì)比選擇出特征唇印,以實(shí)現(xiàn)身份識(shí)別。仿真實(shí)驗(yàn)驗(yàn)證,本文的特征唇印提取算法在較低時(shí)空消耗下,具有較高的識(shí)別率,具有有效性和可用性。

關(guān)鍵詞:內(nèi)唇輪廓;基元唇印;特征唇印;特征點(diǎn)標(biāo)定;Gabor變換

0引言

特征唇印的提取是動(dòng)態(tài)唇形身份識(shí)別技術(shù)中的核心環(huán)節(jié),主要分為基于像素、基于模型以及混合型三類特征提取算法。基于像素的特征提取是直接對(duì)唇部的灰度圖像進(jìn)行特征提取。如文獻(xiàn)[1]采用主成分分析法對(duì)唇部的灰度圖像進(jìn)行特征提取,雖然算法對(duì)唇部的灰度圖像的質(zhì)量要求較低,但易受其他因素的影響致使識(shí)別率有所差異。基于模型的特征提取通過(guò)對(duì)唇部建立相應(yīng)的模型,以模型參數(shù)作為特征信息。文獻(xiàn)[2]將自適應(yīng)的均值模板引入到ASM中,雖然對(duì)唇部輪廓有更強(qiáng)的描述能力,但算法復(fù)雜,實(shí)用性較差。混合型的唇印提取算法結(jié)合了上述兩種算法的優(yōu)點(diǎn)。文獻(xiàn)[3]采用AAM(Active Appearance Model)來(lái)提取特征,算法將輪廓模型與主成分分析法相結(jié)合,具有較好的效果,但過(guò)程較復(fù)雜。文獻(xiàn)[4]提出了基于唇色濾波器的嘴唇特征提取, 適用于口型識(shí)別的實(shí)時(shí)唇定位。文獻(xiàn)[5]運(yùn)用DCT+LDA 的方法提取唇讀視覺(jué)特征,但現(xiàn)有特征唇印提取中信息處理量較大、識(shí)別率不高。針對(duì)嘴唇的外沿變化不是特別明顯、需要對(duì)大量數(shù)據(jù)進(jìn)行驗(yàn)證和概括的問(wèn)題,本文采用模型點(diǎn)和Gabor變換相融合的唇印提取算法,利用內(nèi)唇輪廓上關(guān)鍵點(diǎn)建立唇印模型,利用Gabor變換進(jìn)行特征提取,算法在一定程度上降低了復(fù)雜度,同時(shí)具有較高的特征表征能力。

1特征唇印提取模型及相關(guān)規(guī)定

11提取模型的相關(guān)規(guī)定

(1)為了便于敘述,設(shè){a;o;i;u;sh;z}為關(guān)鍵基元,這6個(gè)聲、韻母充分涵蓋了說(shuō)話人的唇型特征。

(2)對(duì)每個(gè)關(guān)鍵基元進(jìn)行圖像標(biāo)定特征點(diǎn)、邊,構(gòu)造不同關(guān)鍵基元的唇部模型,稱為基元唇印。

(3)對(duì)所有基元唇印進(jìn)行多次訓(xùn)練,對(duì)標(biāo)定的特征點(diǎn)、邊取平均值計(jì)算得唇部均值模型,稱為普通模型。

(4)將以身份識(shí)別的唇動(dòng)特征模型稱為特征唇印。

12特征唇印的提取模型

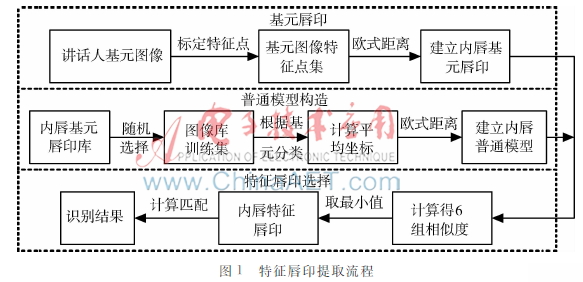

特征唇印的提取主要由基元唇印建立、普通模型構(gòu)造、特征唇印選擇等幾個(gè)階段組成。

(1)基元唇印的建立:從待識(shí)別的基元圖像中選出一幅尚未提取特征的圖像,對(duì)其內(nèi)唇輪廓進(jìn)行特征點(diǎn)標(biāo)定,得到特征點(diǎn)的坐標(biāo)及歐氏距離;(2)普通模型的構(gòu)造:在基元唇印庫(kù)中隨機(jī)選擇一定數(shù)量的基元唇印作為訓(xùn)練集,并根據(jù)基元類型分類,對(duì)每一類每個(gè)特征點(diǎn)求取平均坐標(biāo),構(gòu)造六組普通模型;(3)特征唇印選擇:將講話人的六個(gè)基元唇印及六組普通模型對(duì)應(yīng)起來(lái),然后利用Gabor變換進(jìn)行特征點(diǎn)抽取,計(jì)算相似度,選擇相似度最小的作為特征唇印。流程如圖1所示。

2基于內(nèi)唇輪廓的特征唇印提取算法

內(nèi)唇特征提取算法需要經(jīng)過(guò)基元唇印建立和普通模型構(gòu)造兩個(gè)子過(guò)程。

21基元唇印算法

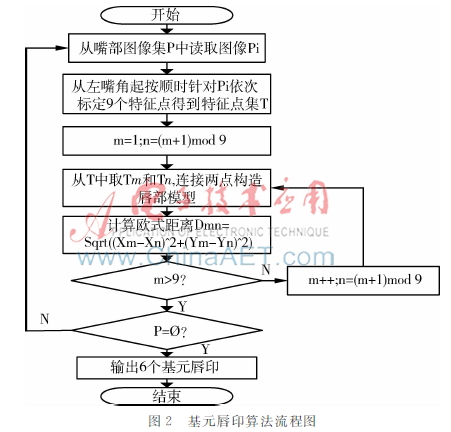

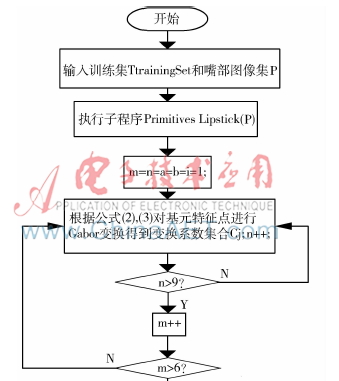

基元唇印的建立是特征唇印提取的前提,算法通過(guò)對(duì)嘴部圖像集進(jìn)行操作得到基元唇印庫(kù)和6個(gè)基元唇印。基元唇印(Primitives Lipstick(P))算法流程如下圖2所示。

設(shè)每個(gè)講話人6個(gè)基元唇印相應(yīng)嘴部圖像集為P={Pi|P1,P2,P3…Pi},每個(gè)Pi中標(biāo)定9個(gè)特征點(diǎn),分別是左右嘴角各1個(gè),內(nèi)唇上沿3個(gè),內(nèi)唇下沿4個(gè),從左嘴角起順時(shí)針標(biāo)定,從而得到Pi的特征點(diǎn)集T={Tj| 1≤j≤9}。然后計(jì)算特征點(diǎn)之間的歐氏距離,這里規(guī)定從Pi的特征點(diǎn)集中選擇編號(hào)相鄰的特征點(diǎn),連接為特征邊,設(shè)Dmn為Tm、Tn間歐氏距離。

22普通模型構(gòu)造

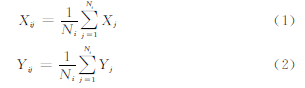

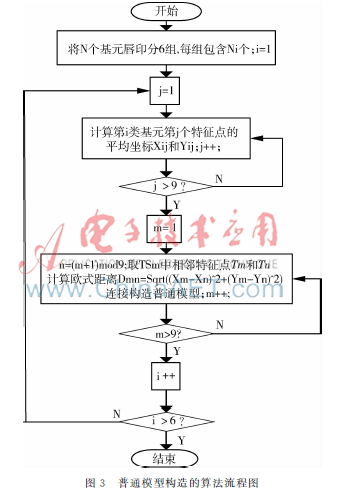

普通模型在一定程度上反映了基元唇印庫(kù)中的平均唇形,是內(nèi)唇特征提取的基礎(chǔ)環(huán)節(jié)。流程為:首先隨機(jī)選擇N個(gè)基元唇印作為訓(xùn)練集TtrainingSet={TSi| 1≤i≤N};然后根據(jù){a;o;i;u;sh;z}對(duì)訓(xùn)練集TtrainingSet進(jìn)行分類得到六個(gè)集合Ki={TSj| 1≤j≤Ni};再者根據(jù)公式(1)和(2)分別求出第i類集合Ni個(gè)基元唇印特征點(diǎn)的坐標(biāo)平均值Xij和Yij。

普通模型構(gòu)造(AverageMouth(TtrainingSet))算法流程圖如圖3所示。

23內(nèi)唇特征唇印提取

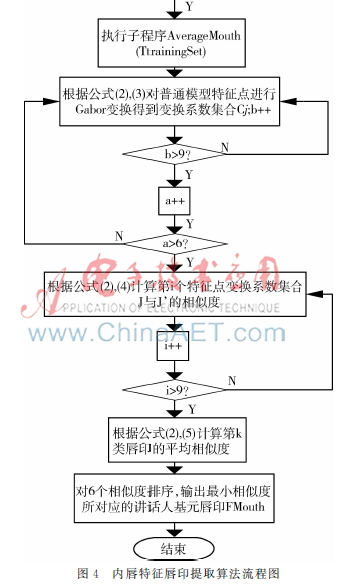

在基元唇印建立和普通模型構(gòu)造兩個(gè)子過(guò)程的基礎(chǔ)上,構(gòu)造內(nèi)唇特征唇印提取算法。

首先根據(jù)基元唇印算法建立講話人的6個(gè)基元唇印;然后在基元唇印庫(kù)中隨機(jī)選擇N個(gè)基元唇印作為訓(xùn)練集,接著利用式(3)對(duì)6個(gè)基元唇印以及訓(xùn)練集的6個(gè)普通模型的9個(gè)特征點(diǎn)進(jìn)行5個(gè)頻位、8個(gè)相位的Gabor分解變換,得到特征點(diǎn)的特征向量[6]。

Cj=Ajexp(iφj)(1≤j≤40)(3)

其中Cj為卷積結(jié)果,Aj為幅值,φj為相位。

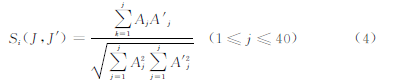

設(shè)J為基元唇印第i個(gè)特征點(diǎn)的Gabor變換系數(shù)集合{Cj|(1≤j≤40)},J′為對(duì)應(yīng)的普通模型第i個(gè)特征點(diǎn)的Gabor變換系數(shù)集合{Jj|(1≤j≤40)},Si為J與J’之間的相似度值,Aj和Aj ′分別為J、J′的幅值,利用角度無(wú)關(guān)的相似度計(jì)算公式(4)可得每個(gè)特征點(diǎn)的相似度。

計(jì)算9個(gè)特征點(diǎn)相似度的平均值,以sk作為基元對(duì)應(yīng)的基元唇印與普通模型之間的相似度。

相似度越小表明識(shí)別率越高,對(duì)sk進(jìn)行排序,選擇相似度最小的基元唇印作為特征唇印。

根據(jù)以上思想并結(jié)合基元唇印和普通模型算法,可設(shè)計(jì)出完整的內(nèi)唇特征唇印提取算法Lipstick Extract (K, P),算法的流程如圖4所示。

3仿真驗(yàn)證

為了驗(yàn)證本算法的可行性,利用MATLAB進(jìn)行仿真實(shí)驗(yàn),實(shí)驗(yàn)選取32個(gè)不同講話人拼讀6個(gè)關(guān)鍵基元的視頻幀,每個(gè)講話人對(duì)應(yīng)6個(gè)關(guān)鍵基元。

31特征點(diǎn)標(biāo)定

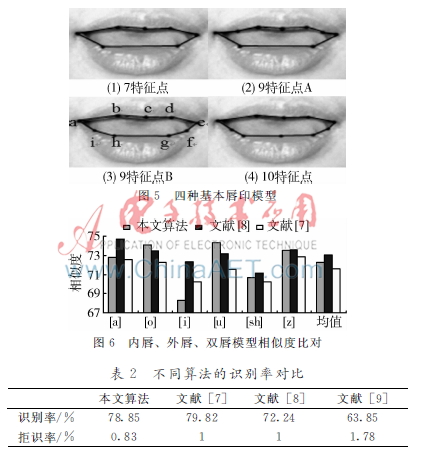

本文選用內(nèi)唇輪廓線上的9個(gè)特征點(diǎn)標(biāo)定模型特征,如圖5所示的9特征點(diǎn)B,用點(diǎn)c捕獲[a]、[o]發(fā)音過(guò)程中嘴唇的高度,用a、e兩點(diǎn)捕獲[o] 、[u]發(fā)音時(shí)嘴角位置,用b、d兩點(diǎn)捕獲嘴唇在發(fā)[o]、[u]、[sh]等音時(shí)的形變,用f、g、h、i四點(diǎn)來(lái)反映嘴唇上下開合時(shí)的距離及[i]、[sh]、[z]發(fā)音時(shí)唇部特征。

32與普通模型間的相似度水平

將文獻(xiàn)[7]、文獻(xiàn)[8]以及本算法所構(gòu)造的基元唇印與普通模型間相似度均值進(jìn)行比對(duì),從圖6中可看出,由于特征點(diǎn)比文獻(xiàn)[7]減少了將近一半,本算法平均相似度值略高于文獻(xiàn)[7],但與文獻(xiàn)[8]相比,具有較低的相似度,說(shuō)明本算法的捕獲信息的能力更強(qiáng)。

33時(shí)間效率

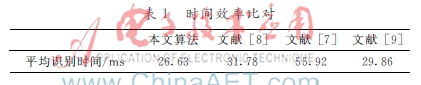

針對(duì)時(shí)間效率,將本文算法與文獻(xiàn)[7]、文獻(xiàn)[8]以及不提取特征唇印直接進(jìn)行識(shí)別的文獻(xiàn)[9]算法進(jìn)行比對(duì),時(shí)間效率比對(duì)結(jié)果如表1。

從表1可以看出,本算法在身份識(shí)別中時(shí)間耗費(fèi)最小,有更好的時(shí)間性能,雖然文獻(xiàn)[9]節(jié)省了提取特征唇印所耗費(fèi)的時(shí)間,但在整個(gè)識(shí)別過(guò)程中耗費(fèi)時(shí)間較多。

34識(shí)別率

針對(duì)識(shí)別率,將本算法與文獻(xiàn)[7]、文獻(xiàn)[8]以及文獻(xiàn)[9]算法進(jìn)行了對(duì)比,結(jié)果如表2所示。

從表2中可知,本算法的識(shí)別率僅略低于文獻(xiàn)[7],但拒識(shí)率最低。說(shuō)明本算法能夠在較低時(shí)空消耗下,保證較高的識(shí)別率。表2不同算法的識(shí)別率對(duì)比本文算法文獻(xiàn)[7]文獻(xiàn)[8]文獻(xiàn)[9]識(shí)別率/%7885798272246385拒識(shí)率/%08311178

4結(jié)論

針對(duì)現(xiàn)有特征唇印提取中信息處理量較大、識(shí)別率不高等問(wèn)題,本文提出了基于內(nèi)唇輪廓的特征唇印提取算法,算法首先在基元圖像上對(duì)內(nèi)唇輪廓特征點(diǎn)進(jìn)行標(biāo)定,建立基元唇印模型,然后通過(guò)均值計(jì)算構(gòu)造普通模型,并利用Gabor變換對(duì)基元唇印和普通模型聯(lián)合特征信息提取,最后通過(guò)相似度對(duì)比選擇出特征唇印,最終實(shí)現(xiàn)身份識(shí)別。仿真實(shí)驗(yàn)驗(yàn)證本文所提出的算法不僅耗時(shí)低,還具有較高的識(shí)別率。

參考文獻(xiàn)

[1] Yang Jian,ZHANG D, Yang Jingyu. Constructing PCA baseline algorithms to rreevaluate ICAbased facerecognition performance[J]. IEEE Transactions on Systems,Man and Cybernetics,2007,37(4):1015-1021.

[2] KIM H C, KIM H J, HWANG W,et al.Facial feature point extraction using the adaptive mean shape in active shape model[C].Computer Vision/Computer Graphics Collaboration Techniques, France, 2007: 421-429.

[3] KATSAMANIS A, PAPANDREOU G, MARAGOS P. Face active appearance modeling and speech acoustic information to recover articulation[J],IEEE Tr.on Acoustics,Speech and Lang,2009,17(3):411-422.

[4] 姚鴻勛,高文,李靜梅.用于口型識(shí)別的實(shí)時(shí)唇定位方法[J],軟件學(xué)報(bào),2000,11(8):1126-1132.

[5] NEFTAN A V, Liang Luhong, Liu Xiaoxing, et al. A coupled HMM for audio-visual speech recognition[C]. International Confzerence on Acoustics Speech and Signal Processing,2002,5(2):2013-2016.

[6] WISKOTT L,FELLOWS J M, N KRUK ger,et al.Face recognition by elastic bunch graph matching[J].IEEE Trans on Patern.Anal Mach Intell, 1997(19): 775-779.

[7] TIDDEMAN B, PERRETT D.Prototyping and transforming visemes for animated speech[C].IN Proceedings of Computer Animation,Geneva,Switzer-land,2002:248-251.

[8] Meng Yingjie, Li Zhaoxia,Hu Yingjie, et al. Speaker identification based on feature mouth shapes [J]. Journal of Information and Computational Science,2009(6): 1209-1216.

[9] POTAMIANOS G, Graf H. P, COSATTO E. An image transform approach for HMM based aotumatic lipreading [C]. Proceeding of the International Conference on Image Processing,Chicagao,1998(3):173-177.