摘 要: 針對多組手語語句中重復出現(xiàn)的手語單詞識別問題,提出了一種識別方法。該方法利用時間規(guī)整算法構(gòu)建手語識別模型,并通過條件迭代算法快速計算最大后驗概率。在南佛羅里達大學公共手語數(shù)據(jù)集進行實驗,證明了該方法具有一定的實用性。

關(guān)鍵詞: 手語識別;動態(tài)時間規(guī)整算法;條件迭代算法

0 引言

在人機交互應用方面,無論是基于文本方式的鍵盤設(shè)備,還是基于圖形方式的鼠標設(shè)備,都無法滿足人們對計算機應用的需求。符合人們?nèi)粘=涣髁晳T的人機交互技術(shù)是最近幾年熱門的研究領(lǐng)域。人類日常交流過程中,采用的方式可以分為自然語言和肢體語言兩大類。自然語言包括口語、書面語言;肢體語言包括面部表情、身體姿態(tài)、手勢手語等。其中手語是由一系列規(guī)范的手勢標準組成的獨立語言門類。手語識別技術(shù)對于提高計算機的智能化,完善人機交互應用具有很強的現(xiàn)實意義。

按照所研究的手勢種類的不同,可以將手勢識別分為靜態(tài)手勢識別和動態(tài)手勢識別兩類。

(1)靜態(tài)手勢是指在整個手勢運動時間段中,只需考慮在手形變化過程中各個指尖的位置變化,而手掌沒有發(fā)生整體性位移。例如STREN H I等人[1]設(shè)計了一種利用靜態(tài)手勢集作為汽車導航設(shè)備指令集的汽車平臺人機交互系統(tǒng)。MAUNG T H H[2]利用手勢圖像的直方圖特征通過神經(jīng)網(wǎng)絡(luò)進行手勢識別,其手勢平均識別率為90%。楊波等人[3]利用手勢圖像的區(qū)域形狀特征提出一種基于手勢空間分布特征的手勢識別算法,在環(huán)境光照相對穩(wěn)定的條件下,對于差異較大的手勢識別率高達98%。Yao Minghai等人[4]利用在線PCA改進算法進行靜態(tài)手勢識別,其識別率為90.48%。

(2)動態(tài)手勢是指在整個手勢運動時間段中,不但手掌發(fā)生整體性位移,并且整個手形也在發(fā)生變化。動態(tài)手勢與靜態(tài)手勢相比更為復雜,也更加符合實際應用需求,成為最近幾年手勢識別的一個熱點。例如Yang Ruiduo等人[5]利用一種嵌套式動態(tài)編程方法,從視頻序列中識別手語信息,其實驗結(jié)果比傳統(tǒng)的條件隨機域模型提高40%。Yin Ying等人[6]開發(fā)了一種新的三維手勢人機交互系統(tǒng),其中包括3種用戶類型和12種手勢指令集,孤立手勢詞識別率為95.6%,連續(xù)手勢詞識別率為73%。ELMEZAIN M[7]利用HMM算法識別“0~9”手勢運動軌跡,其孤立手勢詞識別率為98.6%,連續(xù)手勢詞識別率為94.29%。THEODORAKIS S等人[8]提出一種改進的多數(shù)據(jù)流HMM算法,這種算法在進行動態(tài)手勢識別時允許部分手語之間的數(shù)據(jù)流異步,其識別效果比使用傳統(tǒng)的HMM算法提高8.3%。

本文在視頻圖像處理技術(shù)的基礎(chǔ)上,針對常用手語視頻中目標手勢特征進行研究和提取,提出了一種基于條件迭代算法的手語識別方法。該方法通過對用戶提供的每條手語視頻中各個手勢動作進行分析,識別反復出現(xiàn)的目標手勢。

1 基于條件迭代算法手語識別方法

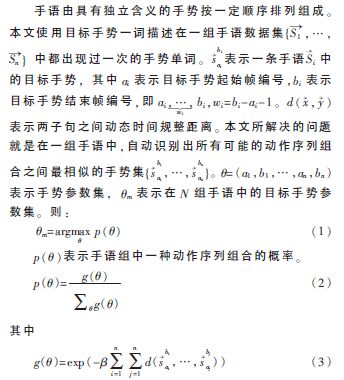

1.1 手語識別中BTW模型

在實際中,同一種手勢所用的時間會因為表達習慣和表述場景不同而有所差異,這就導致同一種手勢動作對應的采樣數(shù)據(jù)幀數(shù)是變化的。因此,可以用動態(tài)時間規(guī)整算法(Dynamic Time Warping,BTW)來計算不同手勢序列之間的距離,最終實現(xiàn)手勢的識別。

是一個規(guī)模參數(shù),它控制概率空間中的峰值,影響條件迭代算法(ICM)的收斂速度。g表示參數(shù)集的子序列之間相似性。由于式(2)中分母涉及了所有可能的組合相似性的總和,計算量非常大,因此p難以計算。

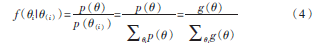

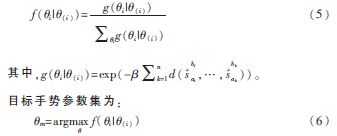

為了方便目標手勢識別的實現(xiàn),本文進行以下處理。?茲i表示一組手語中第i條手語的動作序列參數(shù)集合{ai,bi},并且?茲(i)表示同組手語中其余手語的動作序列參數(shù)集合{a1,b1…ai-1,bi-1,ai+1,bi+1…an,bn}。由式(2)可以推導出?茲i在整個動作序列參數(shù)集合中的條件概率為:

將式(3)代入式(4)中,整理得到:

在實際手語識別問題中,手語視頻的幀數(shù)很多,如何快速求解BTW模型的后驗概率最大化是個關(guān)鍵問題。條件迭代算法計算量較小沒有較復雜的操作,適合通過計算機來實現(xiàn),因而具有實用價值。

1.2 手語識別中條件迭代算法

條件迭代算法(Iterated Conditional Modes,ICM)[9]是一種收斂速度快的最大后驗概率估算方法。采用ICM算法自動識別目標手勢的核心思想是:在一組手語中,采用DTW算法計算兩幀之間的相似性;定義手勢序列組合結(jié)果與其余組合結(jié)果的比值作為該種序列組合的后驗概率;通過迭代計算所有手勢序列組合的后驗概率,選擇最大后驗概率的序列組合作為目標手勢識別結(jié)果。該方法具體步驟如下:

(1)在起始幀識別過程中,計算每一幀作為目標手勢起始幀的后驗概率,根據(jù)后驗概率分布,構(gòu)建起始幀備選集。

(2)在結(jié)束幀識別過程中,首先由起始幀備選集確定結(jié)束幀識別起點和搜索范圍。然后計算搜索范圍內(nèi)每一幀作為目標手勢結(jié)束幀的后驗概率,對應每一個備選起始幀,選擇后驗概率最大的結(jié)束幀,構(gòu)建目標手勢結(jié)束幀備選集。

(3)比較備選集中起始幀與結(jié)束幀后驗概率的乘積,標注后驗概率乘積最大的起始幀與結(jié)束幀。

(4)考慮人們的視覺認知習慣,將視頻幀重新組合,還原完整目標手勢序列。

2 基于條件迭代算法手語識別器設(shè)計與實現(xiàn)

隨著手勢識別的深入研究,相關(guān)學者給出多種定義手勢的方法。王西穎等人[10]按照手勢運動特點將手勢分為非運動手勢和運動手勢。其中非運動手勢包括需要考慮手形變化過程中各個手指之間關(guān)系的跟蹤類手勢和只需考慮手形變化結(jié)果的非跟蹤類手勢。而在運動手勢中,又可分為運動過程中沒有手形變化的非變形類手勢和運動過程中存在手形、手指變化的變形類手勢。

本文使用具有完整含義的手語視頻作為手勢識別數(shù)據(jù)輸入,通過比較不同圖像差分法的分割效果,采用二幀差距離的差分圖像與YCgCr顏色特征相結(jié)合的方法進行目標區(qū)域分割。在實際的手語中,每一個手勢詞內(nèi)部都變化平緩,而手勢詞之間存在明顯變化的起始幀、結(jié)束幀。依據(jù)相鄰幀之間歐式距離,采用滑動窗口提取手語視頻中的關(guān)鍵幀,可以將動態(tài)視頻的研究問題簡化成對靜態(tài)圖像的研究問題。同時在關(guān)鍵幀中提取目標區(qū)域重心和目標區(qū)域外部輪廓鏈碼兩種特征,盡可能地減小手勢識別的計算量,提高識別性能。如圖1所示,本文設(shè)計的手勢識別系統(tǒng)包括數(shù)據(jù)輸入、目標區(qū)域分割、關(guān)鍵幀提取、特征提取、手勢識別五大部分。

3 實驗分析

本文利用MATLAB平臺進行實驗,選擇南佛羅里達大學計算機視覺實驗室提供的公共手語數(shù)據(jù)集。該視頻數(shù)據(jù)集包括136個美國手語短句(ASL)的視頻序列,按照待識別的目標手勢不同,共分成10組。實驗結(jié)果按照公共數(shù)據(jù)集所提供的參考標準進行分析。實驗結(jié)果為:136條手語中,完全識別正確有119條,部分識別正確有0條,識別錯誤有17條,識別率為87.5%。對比國外相關(guān)研究成果,參考文獻[11]與本文采用相同手語公共數(shù)據(jù)集進行實驗,其識別結(jié)果為:136條手語中,完全識別正確有98條,部分識別正確有20條,識別錯誤有18條。因此本文提出的手語識別方法具有一定的優(yōu)勢。

4 結(jié)論

手勢是手語中最小的、有意義的單位,具有使用靈活、信息量豐富的特點。本文提出一種能夠從一組日常手語短句中識別出目標手勢的方法,實驗驗證了該方法的有效性。

參考文獻

[1] STERN H I, WACHS J P, EDAN Y. Optimal consensus intuitive hand gesture vocabulary design[C]. 2008 IEEE International Conference on Semantic Computing, 2008: 96-103.

[2] MAUNG T H H. Real-time hand tracking and gesture recognition system using neural networks[C]. World Academy of Science, Engineering and Technology, 2009:466-477.

[3] 楊波,宋曉娜,馮志全,等.復雜背景下基于空間分布特征的手勢識別算法[J].計算機輔助設(shè)計與圖形學學報,2010,22(10):1841-1848.

[4] Qu Xinyu, Yao Minghai, Gu Qinlong, et al. Adaptive subspace based online PCA algorithm for mobile robot scene learning and recognition[C]. 2011 International Conference on Intelligent Human-Machine Systems and Cybernetics(IHMSC), IEEE, 2011(1):205-209.

[5] Yang Ruiduo, SARKAR S, LOEDING B. Handling movement epenthesis and hand segmentation ambiguities in continuous sign language recognition using nested dynamic programming[J]. Pattern Analysis and Machine Intelligence, 2010, 32(3):462-477.

[6] Yin Ying, DAVIS R. Toward natural interaction in the real world: real-time gesture recognition[C]. International Conference on Multimodal Interfaces and the Workshop on Machine Learning for Multimodal Interaction, ICMI-MLMI′10, 2010: 1-8.

[7] ELMEZAIN M, AL-HAMADI A, APPENRODT J, et al. A hidden markov model-based continuous gesture recognition system for hand motion trajectory[C]. 19th International Conference on Pattern Recognition, ICPR 2008, 2008:1-4.

[8] THEODORAKIS S, KATSAMANIS A, MARAGOS P. Product-HMMs for automatic sign language recognition[C]. IEEE International Conference on Acoustics, Speech and Signal Processing, ICASSP 2009, 2009: 1601-1604.

[9] BESAG J. Statistical analysis of dirty pictures[J].Journal of the Royal Statistical Society,1986(48):259-302.

[10] 王西穎,戴國忠.面向虛擬現(xiàn)實的層次化交互手勢建模與理解方法[J].計算機輔助設(shè)計與圖形學學報,2007,19(10):1334-1341.

[11] NAYAK S, SARKAR S, LOEDING B. Automated extraction of signs from continuous sign language sentences using iterated conditional modes. Computer vision and pattern recognition[C]. IEEE Conference on Computer Vision and Pattern Recognition, CVRP 2009, 2009: 2583-2590.