摘 要

如今機器學習以及深度學習在各個領域廣泛應用,包括醫療領域、金融領域、網絡安全領域等等。深度學習的首要任務在于數據收集,然而在數據收集的過程中就可能產生隱私泄露的風險,而隱私泄露將導致用戶不再信任人工智能,將不利于人工智能的發展。本文總結了目前在深度學習中常見的隱私保護方法及研究現狀,包括基于同態加密的隱私保護技術、差分隱私保護技術等等。

01

研究背景

1.1 隱私泄露風險

2006 年 Hinton[1] 和 他 的 學 生 在《Science》上發表了一篇名為“Reducing the Dimensionalityof Data with Neural Networks”的文章,開啟了深度學習在學術界和工業界的浪潮,同時也將人工智能推向了一個新的高潮。目前,在人工智能的幾乎所有領域,深度學習技術已經遠遠超過了傳統方法的性能,包括計算機視覺、音頻處理、自然語言處理、大數據分析等。

推動深度在各個領域取得巨大成功主要有以下幾個因素:

(1) 數據井噴,全球數據中心數據量在未來幾年年均增速 40%。

(2) 計算能力突破,基于大型 GPU 集群的強大計算能力,使得訓練深度神經網絡的速度從2006 年到 2016 年提升了 255 倍。

(3) 算法突破,算法突破推動 AI 技術成熟和實用化。

對于一些大型的網絡企業,用戶的照片、語音、視頻、文本等數據可以被收集和保存,以備將來使用。正因為如此,深度學習領域中大部分成功的應用都是大型組織,它們既有大量有價值的數據,又有足夠的計算能力來訓練深度模型,以改進其產品和服務。

雖然深度學習帶來了巨大的好處,但它需要收集大量的數據,這些數據涉及用戶的隱私信息,例如用戶興趣、愛好、個人信息等,這些隱私數據的泄露會導致不可預估的財產以及生命安全問題。

1.2 隱私保護相關法律

隨著互聯網的快速發展以及隱私泄露問題日益嚴重,為減輕隱私泄露帶來的負面影響,美國、歐盟、中國等國家正在不斷的通過完善數據安全和隱私保護法律法規對企業以及個人進行監管。

美國是最早通過法律法規對隱私進行保護的國家,其在 1974 年通過并發布的《隱私法案》是美國最重要的一部保護個人隱私的法律法規,到 20 世紀 80 年代又先后制定和頒布了《電子通訊隱私法案》《電腦匹配與隱私權法》以及《網上兒童隱私權保護法》。1980 年,經濟合作與發展組織(OECD)在《關于保護隱私和個人信息跨國流通指導原則》中揭示了個人信息保護八大原則,即收集限制原則、數據質量原則、目的明確原則、使用限制原則、安全保障原則、公開性原則、個人參與原則和問責制原則。這些指導原則對全球各國的立法產生了巨大的影響,有“已經成為制定個人信息保護文件的國際標準”之稱。

我國也在多部法律中對隱私權進行保護,比如在《侵權責任法》中規定了若干種承擔侵權責任的方式;《中華人民共和國憲法》第三十八條規定:“中華人民共和國公民的人格尊嚴不受侵犯。”等等。同時我國還在制定專門的《個人信息保護法》《中華人民共和國網絡安全法》等法律對網絡數據以及用戶隱私進行保護。

本文總結了在使用深度學習的同時保護用戶隱私信息的方法,主要包括同態加密隱私保護技術、差分隱私保護技術。同態加密和差分隱私是密碼學中常見的隱私保護手段,這兩種方法被運用于深度學習過程中的隱私保護,具有顯而易見的效果。

02

同態加密隱私保護技術

2.1 同態加密技術

假設存在加密函數 f,使得明文 M 加密后變成密文 M‘,明文 N 加密后變成密文 N’,即f(M)=M‘,f(N)=N’,存在 f 的解密函數 f-1 能夠將 f 加密后的密文解密成加密前的明文。將 M‘與 N’相加得到 P‘,如果解密函數 f-1 對 P’解密后的結果等于 M 和 N 相加的結果,即 f-1(P‘)= f-1 (M'+N’)=M+N,則 f 是可以進行同態加密的加密函數。

同態加密可以分為加法同態、乘法同態以及全同態。加法同態指的是加密算法滿足f(M)+f(N)=f(M+N),乘法同態指的是加密算法滿足f(M)*f(N)=f(M*N)。而全同態加密指的是一個加密函數同時滿足加法同態和乘法同態,全同態加密函數可以完成加減乘除、多項式求值、指數、對數、三角函數等運算。

常見的 RSA 算法對于乘法操作是同態的,Paillier 算法則是對加法同態的,Gentry 算法則是全同態的。

2.2 同態加密技術應用

2.2.1 數據處理與隱私保護

大數據時代下的海量個人信息存儲與處理是隱私保護面臨的關鍵問題,用戶往往不希望將個人資料、保密文件、隱私信息存儲在服務提供商中,而人工智能時代又需要對這些用戶信息進行挖掘分析。同態加密是解決這一矛盾的新技術,用戶可以將個人敏感信息加密后存儲在服務提供商或者云端服務中,服務器可以對密文進行處理以及分析,并將密文結果返回給用戶,只有用戶能夠解密密文結果。

2.2.2 密文檢索

當越來越多的加密數據存儲在服務器或者云端時,對加密數據的檢索成為了一個急需解決的問題。現有的密文檢索算法包括線性搜索、公鑰搜索和安全索引可以解決對服務端的加密數據進行檢索問題,然而這些方法需要花費較高代價并且只能運用于小規模數據集中。基于全同態加密的密文檢索方法可以直接對加密數據進行檢索,對密文做基本的加法和乘法能夠有效降低運算復雜度,同時也不改變相應的明文順序,既保護了用戶的數據安全,又提高了密文的檢索效率。

2.2.3 數字水印

目前數字水印技術已經成熟地運用在數字產品的版權保護中,然而數字水印系統也存在安全挑戰,例如對水印算法、水印密鑰的惡意攻擊,從而破譯水印并且偽造水印。使用同態加密技術對數字水印進行加密后嵌入,在檢測水印時首先需要對水印進行同態解密,該方法能夠有效抵抗數字水印的非授權攻擊。

2.3 基于同態加密的深度學習中隱私保護技術

同態加密的核心是能夠直接在密文上做運算,運算結果解密后與明文運算結果相同,這是對用戶隱私的最直接和有效的保護手段。在機器學習和深度學習過程中使用同態加密對數據加密然后分析計算,能夠很好地解決許多領域要求數據保密、安全的問題。同態加密可以確保在密文上進行計算而不進行解密,從而解密的結果與對明文執行相同計算得到的結果相同。

由于目前的同態加密方案仍然存在許多局限,如只支持整數數據,需要固定的乘法深度,不能無限期地進行加法和乘法運算,全同態加密不支持比較和取最大值等操作。因此,現有的同態加密方案不能簡單地應用于機器學習以及深度學習中。目前常用的解決策略有兩種:①通過安全的多方計算來構造一種適合于基于同態加密的機器學習算法的協議,并通過執行該協議來完成該算法;②尋求原始機器學習算法的近似算法,使其仍然可以使用同時不依賴交互方案,并且滿足同態加密方案的數據和操作要求。

在機器學習和深度學習的預測過程中,利用同態加密算法的性質對數據進行加密,然后在加密訓練集上進行機器學習以及深度學習的建模訓練,同樣使用訓練好的模型對加密的測試集進行預測,返回的預測結果也是密文,從而有效地保護用戶隱私數據。在 2007 年,Orlandi就提出了利用同態加密技術結合多方安全計算使神經網絡具有處理加密數據的能力,并且考慮到了神經網絡本身的安全性。2011 年,Barni等人將基于同態加密的神經網絡應用于心電圖分類中,可以實現遠程服務器對客戶提供的生物醫學信號進行分類,而不獲取任何有關信號本身的信息和分類的最終結果。

2016 年,Dowlin等人提出一種可以應用于加密數據的神經網絡 CryptoNets,同時作者證明云服務能夠將神經網絡應用于加密數據以進行加密預測,并以加密的形式返回這些預測。這些加密的預測可以發送回能夠解密它們的密鑰所有者。該網絡對minist 數據集的識別精度達到了 99%。在 2017年,Hesamifard等在訓練階段使用Chebyshef多項式來近似模擬激活函數,從而證明了利用加密數據訓練神經網絡,進行加密預測,并以加密形式返回預測是可行的和實用的,該方法比 CryptoNets 在 MNIST 數據集上的精度提高了0.52%。

為了解決基于全同態加密技術的機器學習巨大的計算開銷問題,Baryalai等提出了一種非共謀雙云模型 (CloudA,CloudB),該模型使用 Paillier 密碼系統提高運算速度,減少運算開銷。在訓練階段,加密也可以用來保護敏感數據集。Xie等利用 Stone—Weierstrass 理論,提出crypto-nets 在密文上做預測,利用同態加密和對激活函數的修改以及對神經網絡的激活函數和訓練算法的修改,并證明了所提出的加密網絡的構造是可行的。該方法為在不侵犯用戶隱私的情況下建立基于云的安全神經網絡預測服務奠定了基礎。Zhang等提出了一種基于 BGV 加密方案的保密雙投影深度計算模型(PPDPDCM),給出直接在密文上訓練神經網絡的解決方案。

目前,利用加密技術來保護機器學習以及深度學習中的用戶敏感數據已經取得較大進展,包括在預測階段以及訓練階段的數據加密。但是在使用同態加密的過程中存在資源消耗的問題,深度學習本身已經消耗了大量的計算資源,結合同態加密技術將大大增加深度學習的計算量。如何在結合同態加密算法而盡量減少對深度學習性能的影響將是未來主要的研究方向。

03

差分隱私保護技術

3.1 差分隱私保護技術

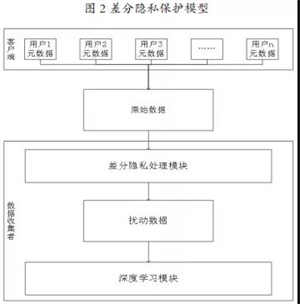

差分隱私的任務是提供一種關于輸出的概率分布的機制或者協議,允許用戶對數據進行一定程度的修改,但不影響總體輸出,從而使得攻擊者無法知道數據集中關于個人的信息,達到隱私保護的作用。

差分隱私指的是存在兩個之間至多相差一條記錄的數據集 D 和 D‘以及一個隱私算法 A,Range(A) 為 A 的取值范圍,若算法 A 在數據集D和D’上任意輸出結果O(O ∈ Range(A))滿足不等 Pr[A(D)=O] ≤ eε×Pr[A(D' )=O] 時,A 滿足 ε- 差分隱私。差分隱私最主要的方法是在數據集中添加噪聲來實現的,常用的噪音機制包括Laplace機制和指數機制,Laplace 機制適用于連續型數據集,而指數機制適用于離散型數據集。

3.2 深度學習中的差分隱私保護技術

差 分 隱 私 (differential privacy) 是一種基于差分隱私機制的隱私保護技術,這個概念是Dwork在2006年提出來的,通過在原始數據中引入噪聲,達到使至多相差1個數據的2個數據集查詢結果概率不可分的目的。

差分隱私保護分為集中式學習和分布式學習兩大類,Abadi于2016年提出的基于差分隱私的深度學習算法基于集中式學習,該方法在梯度下降的過程中利用梯度增大擾動方法來報敏感數據,并詳細分析了差異化隱私的框架下的隱私成本。實驗已經證實了可以在適度的隱私預算下,以可管理的軟件復雜性、訓練效率和模型質量成本,訓練具有非凸目標的深度神經網絡。

2017 年,Papemot等提出用半監督知識遷移方法來解決深度學習中訓練數據隱私泄露問題,以黑盒的方式將多個模型與不相交的數據集(例如來自不同用戶子集的記錄)相結合。由于改進了隱私分析和半監督學習,作者在 mnist 和 svhn 上實現了最先進的隱私/效用權衡。Ji Wang于2018年提出了一種對本地數據進行擾動變換的機制,該機制基于差分隱私計算方法,同時使用噪聲訓練方法增加云端深度神經網絡對移動設備提交的擾動數據的魯棒性,該機制解決了將數據從移動設備傳輸到云中心時的隱私泄露問題。

在聯合分布式學習環境中,數據所有者分布式訓練具有相同目標的神經網絡模型,根據自己的數據集獨立訓練,但共享訓練結果。Shokri和 Shmatikov在 2015 年提出了一個共同分布式深度學習方案來保護隱私,首次將隱私保護的概念引入深度學習。同時利用現代深度學習中使用的優化算法,即基于隨機梯度下降的優化算法,可以實現異步并行和執行,在引入噪聲后,每個參與者將一小部分局部梯度參數上傳到中心參數服務器。

每次更新本地參數時,都會從服務器下載最新的漸變參數進行更新,這樣就允許參與者在自己的數據集上獨立訓練,并在訓練期間有選擇地共享模型關鍵參數的小子集。參與者在保留各自數據的隱私的同時,仍然受益于其他參與者的模型,從而提高他們的學習準確性,而不僅僅是通過自己的輸入實現的。

作者同時證明了在基準數據集上的隱私保護深度學習的準確性。在此基礎上,Mohassel采用隨機梯度下降法,提出了一種新的高效的線性回歸、邏輯回歸和神經網絡訓練保密機器學習協議。該協議屬于雙服務器模型,數據所有者將其私有數據分配給兩個非協作服務器,這些服務器使用安全的雙方計算(2PC)對聯合數據上的各種模型進行訓練。

04

前景展望

隨著深度學習的興起,人工智能在各個領域迎來新的一波發展熱潮,然而在人工智能迅速發展的同時,其安全與隱私問題也引起了人們的關注,人工智能的安全和隱私的威脅已經阻礙了人工智能的發展。保護用戶隱私成為人工智能發展的關鍵,當前基于深度學習的隱私保護的研究仍處于起步階段,還有許多亟待解決的問題,我們可以從以下幾個方面進行重點研究從而找到有解決人工智能中隱私泄露的有效方法。

(1)建立完善的評估機制與法律手段。建立一套統一的隱私泄露安全評估標準以及衡量標準,完善相關法律,從源頭上制止企業和組織非法泄露用戶信息。

(2)高效的加密算法。加密技術是最直接有效的隱私保護手段,但目前同態加密技術運算開銷過大,結合本身就消耗大量計算資源的深度學習算法,將大大降低算法性能。因此,研究高效的加密方法保護用戶隱私是一個重要研究問題。